Novinky

Autonomní vojenští roboti a etika

David Černý

Podoby válčení se v dějinách vyvíjely v závislosti na celé řadě faktorů. Jak ve své knize The Sling and the Stone. On War in the 21st Century dokládá plukovník americké armády Thomas X. Hammes, klíčovými prvky určujícími způsoby vedení válek a válečné strategie byly kromě vědeckotechnického pokroku také podmínky politické, ekonomické a společenské. Například napoleonské války by nebyly možné bez vynálezu střelného prachu, mušket, lehké artilérie a možnosti dálkové komunikace (vědeckotechnický pokrok), vzniku národních států (politické podmínky), pokročilého zemědělství a dopravy (ekonomické podmínky) a patriotismu (společenské podmínky).

Podmínky se mění, konstantní ale zůstává – zvláště v posledních letech – mimořádný vědecký a technický vývoj, v posledních letech zvláště na poli umělé inteligence a robotiky. Peter Warren Singer ve své knize Wired for War z roku 2009 píše, že do budoucích válek budou zapojeni roboti různé velikosti, návrhu, schopností, autonomie a inteligence. Jeho předpověď je již realitou. Umělá inteligence a roboti se využívají pro celou řadu činností, od plánování, testování strategií, logistiky, přes průzkum terénu, likvidaci min, ničení strategických cílů a zabíjení protivníků. Zdá se, že lidstvo již podruhé překročilo pomyslný Rubikon; poprvé se stvořením atomové bomby, v současnosti s vývojem autonomních letálních vojenských robotů schopných operovat zcela samostatně, včetně rozhodnutí o likvidaci cíle. V dnešních konfliktech hrají významnou roli dálkově řízené vojenské stroje, které se využívají k likvidací cílů a nepřátelských vojáků (robot-on-human warfare), jak ale píše americký generál David Petraeus ve své knize Conflict. The Evolution of Warfare from 1945 to Gaza, brzy budeme svědky boje robotů proti robotům (robot-on-robot warfare), nad kterým my lidé do značné míry ztratíme kontrolu. Minimálně proto, že čas je během válečných operací klíčový; stoje se dokáží rozhodovat mnohem rychleji než lidé a jedinou možností bude jejich plná autonomie.

Co je to robot?

Plně autonomní letální vojenští roboti jsou roboti, kteří mají v podmínkách válečného konfliktu jednoznačně určený cíl: najít a zlikvidovat nepřátelské cíle. Finalitou (konečným cílem) těchto strojů, která se promítá do jejich vývoje, designu i operačního uplatnění, je zabíjení a ničení vojenských cílů, což samozřejmě vyvolává celou řadu etických otázek. Než k nim přistoupíme, je třeba alespoň zběžně určit, co přesně budeme v kontextu etické reflexe rozumět „plně autonomními letálními vojenskými roboty“.

V první řadě se jedná o roboty. Ale i když je toto slovo dnes poměrně široce rozšířené, je překvapivě obtížné přesně definovat jeho význam a jasně vymezit třídu artefaktů, které jsou roboty, a odlišit ji od těch, které roboty nejsou. Naše představy a intuice ohledně robotů (alespoň v našem západním kulturním okruhu) jsou utvářeny mýty, antickými i moderními (sci-fi), které zvláště v moderní době, zhruba od 19. století, ve své vědeckotechnické imaginaci předbíhají současný stav poznání a technických možností. Lze říci, že roboti zde s námi byli dávno před tím, než vznikla robotika jako obor snažící se přenést tyto artefakty ze sféry literární a filmové představivost do reálného světa. Snad každý z nás proto má nějakou představu o tom, co je „skutečný“ robot a co nikoli, namísto reálných robotů jsou ale tyto představy nerealisticky utvářeny fiktivními stoji, jako je známá dvojice R2-D2 a C-3O z filmové franšízy Hvězdné války nebo Bender (a další) ze seriálu Futurama. Dokonce ani mezi odborníky – robotiky – neexistuje shoda na tom, jak roboty definovat. Americký robotik I. L. Nourbakhsh proto varuje, že bychom robotikům neměli klást otázku, co je to robot, protože odpověď se neustále mění společně s dynamickým pokrokem na poli robotiky a umělé inteligence.

V tomto textu se budu držet jedné z nejrozšířenějších definic robotů, kterou předložil americký robotik G. A. Bekey:

Robot. Robot je artefakt, který:

1. Prostřednictvím senzorů vnímá své okolí.

2. Zpracovává smyslové vjemy (percepty) a vytváří si plány jednání.

3. Disponuje akčními členy (aktuátory), které mu umožňují aktualizovat plány v nějakém prostředí.

Robotem tedy rozumíme nějaký stroj, který existuje ve fyzickém světě, dokáže vnímat své okolí, zpracovávat získaná data, vytvářet si nějaké plány činnosti v závislosti na uložených úkolech, a nakonec tyto úkoly plnit prostřednictvím různých typů akčních členů (kolečka, pásy, manipulátory apod.). Tato definice sice poměrně jasně určuje, jaký artefakt máme považovat za robota, přesto však ponechává poměrně širokou šedou zónu artefaktů, o nichž si nejsme jisti, zda roboty jsou, či nikoli. Někteří autoři například nepovažují za nutné, aby robot existoval v reálném prostředí, některé softwarové programy lze proto považovat za roboty. Jiní požadují, aby roboti disponovali alespoň nějakou základní mírou autonomie, takže programovatelné průmyslové roboty za roboty v „pravém“ slovy smyslu nepovažují. Myslím si, že neexistuje žádné jednoznačné řešení tohoto problému, musíme prostě přijmout jistou míru nejistoty, dokonce i relativismu, a nějak se rozhodnout. V některých kontextech je například užitečné považovat za roboty i software, v jiných to nutné není. V dalších je zase vhodné zahrnout do rodiny robotů i průmyslové roboty apod.

V tomto reportu budu roboty chápat ve shodě s výše uvedenou definicí, kterou blíže vymezuji následujícím způsobem:

Robot*. Robot je artefakt, který:

1. Existuje ve fyzickém světě a má tělesnou podobu.

2. Prostřednictvím senzorů vnímá své okolí.

3. Zpracovává smyslové vjemy (percepty) a vytváří si plány jednání.

4. Disponuje akčními členy (aktuátory), které mu umožňují aktualizovat plány v nějakém prostředí.

Autonomie

Roboti jsou stroje stvořené k tomu, aby plnily nějaké úkoly, jejich autonomii tedy můžeme definovat vzhledem k těmto úkolům (task autonomy) následujícím způsobem:

Autonomie. Robot R je autonomní při řešení úkolu T (R je T-autonomní), pokud neexistuje systém S takový, že S ovlivňuje řešení T robotem R.

V této podobě však definice příliš informativní není, proto ji nyní blíže vysvětlím. Systémem S zde budu vždy myslet člověka (byť lze pomýšlet i na umělé systémy ovlivňování a kontroly realizace T) a jeho vztah k T specifikuji prostřednictvím tří v literatuře zavedených pojmů. Mějme tedy R, S a nějaký T, potom mohou existovat tři úrovně T-autonomie R:

Úrovně T-autonomie. Pro nějakého R, systém S a úkol T může platit:

1. S je v operační smyčce R (in the loop).

2. S je nad operační smyčkou R (on the loop).

3. S je mimo operační smyčku R (out of the loop).

V případě i) platí, že konečný cíl jednání, například likvidace cíle, schvaluje či přímo provádí člověk. Jiné cíle – instrumentální cíle nutné k naplnění T – však může autonomně provádět R. Například dron může v plně autonomním režimu hlídkovat nad určitým územím, identifikovat cíl a požádat operátora, aby schválil/provedl konečný krok. Vzhledem k T tedy R autonomní není, může však být v různé míře autonomní vzhledem k instrumentálním cílům.

Modalita „nad operační smyčkou“ je již plně autonomní, protože konečný úkol je splněný strojem bez toho, že by žádal člověka o svolení/provedení posledního kroku. O této formě plné autonomie můžeme hovořit jako o dozorované autonomii (supervised autonomy). Již nastupující budoucnost válčení však představují plně autonomní stroje, které jsou nezávislé na člověku a jeho dohledu. Hlavním důvodem je reakční čas, který se nasazováním strojů nesmírně zkracuje a v kontextu reálného nasazení znemožňuje efektivní kontrolu ze strany člověka. Nechci tím říci, že žádný dohled nad stroji nebude možný či žádoucí, ale nebude součástí efektivního provádění konkrétního úkolu. Pokud se například ukáže, že nějaký robot zareagoval chybně, je možné ho ex post vypnout, nebude ale v lidských možnostech vypnout ho dříve, než chybná reakce proběhne. Stejně tak je možné, že dohled nad stroji budou provádět jiné stroje, takže budoucnost autonomních strojů bude budoucností strojově dozorované autonomie, nepochybně by se ale vynořily otázky ohledně autonomie dohlížejících systémů.

Zdá se mi, že z hlediska etické reflexe vyvolávají dozorované i plně autonomní vojenské robotické systémy takřka stejné otázky, byť se nuance jejich odpovědí mohou lišit (např. v otázce odpovědnosti). Nebude-li to nutné, nebudu v následující etické analýze rozlišovat mezi modalitou „nad smyčkou“ a „ve smyčce“.

Plně autonomní letální vojenští roboti

Nejdříve musím učinit jednu poznámku k terminologii. Někteří autoři hovoří jednoduše o „zabijáckých robotech“ (a vyjadřují tak své morální postoje k těmto moderním technickým artefaktům), jiní o vojenských robotech či letálních autonomních zbraňových systémech. Vojenští roboti (přesněji řečeno, letální vojenští roboti, neboť vojenští roboti plní celou řadu funkcí a jen některé z nich jsou určeny pro letální účely) jsou zřejmě našim představám nejbližší, současně to ale znamená, že si snadno za „vojenského robota“ dosadíme nějakého „Terminátora“ či podobný stroj. Jak jsem ale již napsal, bylo by to chybné. Moderní letální vojenští roboti mají celou řadu podob; mohou být „jedním kusem“ (např. systém SGR-A1), ale mohou mít také podobu bitevních sítí, jejichž jednotlivé složky jsou rozmístěny na fyzicky nespojených či nesousedících platformách. „Oči“ takového systému mohou představovat senzory dronu, řídící jednotka může být umístěna ve vojenském vozidle a akční prvky (např. rakety) na úplně jiném vozidle někde na bitevním poli. Mám ale za to, že jsou-li tyto prvky sjednoceny procesem vnímej-plánuj-jednej, jedná se o roboty, tedy i systém dron-řídící prvek-odpalovací stanoviště je podle mého názoru robotem, podobně jako jím je například izraelský vzdušný obranný systém Iron Dome, jež tvoří celá síť různě rozmístěných senzorů a raket země-vzduch. Vzdáme-li se tedy představy, že robot je nějaký stroj tvořený fyzicky spojenými prvky, můžeme i autonomní zbraňové systémy považovat za roboty. Ze stylistických důvodů budu používat jak výrazy „letální vojenský robot“, tak i „plně autonomní letální zbraňový systém“ a považovat je za synonymní. Následující definice shrnuje předchozí reflexi robotů, autonomie a vojenských robotů:

Plně autonomní letální zbraňový systém (letální vojenský robot). Artefakt A je plně autonomním letálním vojenským systémem (letálním vojenským robotem), pokud platí:

1. A je robotem, tj.

a) A vnímá své okolí prostřednictvím senzorů.

b) A si na základě vjemů vytváří plány jednání.

c) A disponuje akčními členy, které umožňují plnit konečné cíle A.

2. Konečným cílem A je usmrcení protivníků a/či zničení vojenských cílů; instrumentální cíle A jsou zaměřeny k splnění tohoto úkolu.

3. Modalita autonomie A je buď:

a) „na smyčce“ (dozorovaná autonomie),

b) „mimo smyčku“.

Argumenty pro využívání autonomních vojenských robotů

Představa plně autonomních vojenských robotů, kteří „kráčí“ po bojišti a sami se rozhodují, koho zabijí, je v mnoha ohledech hrozivá, byť je poněkud vzdálená realitě a ovlivněná zobrazováním těchto robotů ve sci-fi románech a filmech. Jak jsem již uvedl výše, plně autonomní vojenské letální systémy budou mít celou řadu podob a budou nasazovány v jasně definovaných situacích. Nemělo bychom si je představovat jako Terminátory s ohromnou ničivou silou a plnou autonomií nezávislou na lidech. Přesto ale je představa robotů zabíjejících lidi strašidelná. Existují vůbec nějaké dobré důvody je využívat?

První důvod je vcelku zřejmý. Rostoucí pokroky na poli umělé inteligence a robotiky představuje pro vojenský průmysl ohromné možnosti efektivnějšího a pro lidi bezpečnějšího vedení konfliktů. Nikdo z hráčů na mezinárodním poli nepochybuje o tom, že AI a robotika – nejen v – moderním válčení přinese důležitou geopolitickou a strategickou výhodu státům s nejpokročilejšími systémy vojenských robotů a umělé inteligence. Je s tím samozřejmě také spojeno reálné riziko nového (zřejmě již probíhajícího) závodu ve zbrojení, ale to je námitka, které se budu věnovat později.

Zastánci využívání vojenských robotů překládají celou řadu důvodů, které jsou svou povahou utilitární. Snaží se ukázat,

že je s ním spojena celá řada benefitů, které v konečné analýze převažují možná rizika a negativa.

Podívejme se nejdříve na podmínky ius ante bellum. Ned Dobos je jedním z průkopníků reflexe spadající do kategorie ius ante bellum. Ve své knize Ethics, Security, & the War Machine se zamýšlí nad výcvikem vojáků, který zahrnuje rutinu a dehumanizaci možných nepřátel. Z dějin válečných konfliktů víme, že lidí nejsou přirození zabijáci, dokonce ani ve válce. Zvláště pokud jsou nepřátelská vojska v blízkém kontaktu vojáci na sebe vidí), překvapivé množství z nich buď nevystřelí vůbec, nebo střílí tak, aby nikoho nezasáhli. Z pohledu teorie spravedlivé války to může být problematické, protože to může prodlužovat válečný konflikt se všemi hrůzami, které přináší, a samozřejmě také ohrozit vítězství spravedlivé strany konfliktu. Z lidského a psychologického hlediska to však je pochopitelné. Jedním z cílů vojenského výcviku je prostřednictvím rutiny a dehumanizace vytvořit vojáky, kteří v konfliktu nebudou váhat a zdráhat se zabít svého nepřítele. Podle Dobose to ale znamená, že vojenský výcvik – i v době míru – působí vojákům morální újmu, která se může negativně projevit celou řadu psychických potíží a mít negativní dopady na společnost.

Zastánce využívání vojenských robotů může tyto úvahy chápat jako jeden ze vstupů do utilitaristické úvahy: je-li pravda, že i samotný výcvik vojáků je spojený s negativy (morální újma a jevy z ní vyvstávající), potom je možné udělat hodně dobra prostě tím, že armádu zmenšíme a současně zachováme její bojový potenciál (nebo ho dokonce zvýšíme). Od vojenských robotů si lze slibovat právě toto: nebude třeba tolik lidských vojáků, kteří v době míru musí podstupovat vojenský výcvik. Pakliže to platí, můžeme to v etické reflexi připsat vojenským robotům k dobru.

Další možné etické – nikoli strategické – výhody využívání vojenských robotů lze situovat do oblasti ius in bello. Rozdělím je do několika skupin:

1. Jedním z trvalých problémů vojenských konfliktů je nedodržování pravidel ius in bello, a to ani dobře vycvičenými vojáky. Důvodů je celá řada: nejasné rozkazy, nedostatečná připravenost na situace, s nimiž se vojáci setkávají, deprese, zlost a nenávist spojená s tím, že umírají přátelé a kolegové, přehnaná agresivita, ale také touha ubližovat či se mstít. Nelegitimní cíle – primárně civilisté a civilní budovy – mohou být ale zasaženy i z jiných důvodů, například v důsledku boje pod tlakem, chybného určení cíle apod. V moderních válkách – na rozdíl od válek středověku a raného novověku – umírá stále více civilistů a další jsou vystavěni nekorektnímu jednání, ponižování, dokonce i mučení, jejich obydlí a majetek mohou být zničeny či rozkradeny. Jednotícím prvkem těchto situací je voják, člověk, který prožívá hrůzy války a často na ně nedokáže adekvátně reagovat. Zastánci využívání vojenských robotů se domnívají, že všechny tyto problémy by mohly – když ne zcela odstranit – ta alespoň efektivně eliminovat stroje obdaření inteligenci a autonomií. Nemají emoce, mohou se proto rozhodovat pod vlivem strachu, hněvu, deprese, touhy po pomstě, majetku či ze sadistických pohnutek. Kromě toho lze očekávat, že budou mít kvalitní senzory a vyšší než lidskou schopnost rozlišovat legitimní a nelegitimní cíle. Podaří-li se naplnit tyto přísliby, mohli by se vojenští roboti stát ideálními vojáky z pohledu etických podmínek vedení vojenského konfliktu: budou efektivně rozlišovat cíle, nebudou jednat pod vlivem emocí či únavy a tím ochrání civilisty a jejich majetek. Hrůzy války se tak nepodaří eliminovat, ale jednu z jejích nejděsivějších podob – zabíjení, mučení, ponižování a okrádání civilistů – by bylo možné výraznou měrou redukovat.

2. Válka představuje masivní zabíjení lidí, kteří si často toto řešení konfliktu nevybrali. Každý zachráněný lidský život je důležitou hodnotou a čím více lidí zachráníme, tím lépe. Etická rozvaha je jednoduchá a přímočará: je-li možné X % vojáků nahradit roboty, znamená to, že X % vojáků nebudeme vystavovat ohrožení na životech a zdraví. Kromě toho, mnozí vojáci, kteří zůstanou součástí aktivních vojenské služby, nebudou muset bojovat přímo, spíše budou fungovat jako údržbáři strojů, budou dohlížet nad jejich zapojením do bojového konfliktu, obsluhovat je v nějakých fázích operací apod. Bylo by naivní si myslet, že konflikty blízké budoucnosti se povedou pouze mezi stroji, nicméně každý potenciálně zachráněný lidský život (vojáci nahrazení roboty) je bodem ve prospěch využívání vojenských robotů.

3. Válka je hrozivá zkušenost. I když vojáci přežijí, mnozí jsou zranění a tato zranění negativně ovlivňují jejich životy. Nemusí se jednat jen o přímé zranění způsobené nepřátelskou zbraní; vojáci bývají vystaveni vlivu škodlivých plynů, chemikálií, nemluvě o psychické újmě, kterou si často z bojiště odnášejí a která je důvodem utrpení nejen jejich, ale i jejich rodiny, blízkých a přátel. Státy také často mají velké problémy poskytnut veteránům válečných konfliktů odpovídající zdravotní péči a sociální podporu, což je zdrojem frustrace, sociálního napětí a nepochybně i formou nespravedlnosti. Jako v předchozím případě, i zde je etická rozvaha přímočará: pokud se díky vojenským robotům podaří tyto negativní faktory omezit, můžeme to chápat jako další bod ve prospěch jejich využívání. Prospěch z toho nebudou mít pouze vojáci, ale také jejich rodiny a blízcí, zdravotní systém, ale vlastně celá společnost.

Mohl bych zde zmínit další možné očekávání přínosy využívání vojenských robotů (např. ekologické), jako základní expozice možných utilitaristických důvodů ve prospěch jejich nasazování v reálných válečných konfliktech je to ale dostačující. Nyní se zaměřím na dva důležité argumenty, které utilitaristické nejsou. První z nich se opírá o povahu vztahu mezi společností a armádou, druhý o platnost revizionistického paradigmatu spravedlivé války.

Moderní společnost je založená na dělbě moci a povinností. Lidé se – metaforicky řečeno – vzdali své absolutní svobody jednat čistě podle své libosti a svěřili se pod správu zákona a státu. Stát naši absolutní svobodu omezuje, ale podmínkou tohoto omezení je, že je to v konečném důsledku ve prospěch všem. Má absolutní svoboda totiž zahrnuje i svobodu ubližovat (pokud chci); pokud se jí vzdávám (a podléhám zákonům své země), je implicitní podmínkou to, že této svobody se vzdává každý. Nemohu ubližovat komu chci, ale současně ani druzí nemohou působit újmu mě. Má absolutní svoboda jakéhosi imaginární přirozeného stavu svobody a neomezenosti je tím limitována, je ale limitována přesně vymezeným způsobem, který prospívá mně i všem ostatním.

Stát se tak stává garantem ochrany mých práv a svobod a vytvořil si mechanismy této ochrany: vnitrostátní (policie a soudní systém) a navenek (armáda jako ochrana proti vnějším hrozbám). Legitimita (nejen armády) je založena právě na tom, že hraje důležitou roli ve společnosti, již jsme jí delegovali: ochranu proti agresi vnějšího (někdy i vnitřního) nepřítele. My jako společnost jsme armádě svěřili nějakou roli a práva, ale tento vztah není jednostranný.

Armáda plní důležitou roli a její legitimita je s touto rolí spojena: chrání nás před nepřáteli. Její povinností je se této role odpovídajícím způsobem zhostit, a to vždy ve vztahu k pověření, které od společnosti má (ochranu našich práv, svobod, společné formy života). My jako společnost od vojáků vyžadujeme hodně, v nejzazším případě ochotu riskovat vlastní životy, z toho ale pro nás plynou nějaké povinnosti.

Vezměme si příklad vojenské posádky bránící město napadené agresorem. Při obraně vojáci plní svou povinnost vůči společnosti, společnost by jim zase měla poskytnout nejlepší možnou výzbroj a vybavení, aby mohli bojovat efektivně a chránili se před újmou na zdraví a životech. Bylo by zjevně absurdní a nemorální, kdyby jim velitel odmítl vydat neprůstřelné vesty a kvalitní palné zbraně. Zdá se mi, že odsud můžeme formulovat obecný princip: pokud má společnost k dispozici prostředky X1, …, Xn, a pokud prostředek Xn před-stavuje nejefektivnější prostředek boje a ochrany zdraví a života vojáků (v mezích ius in bello), máme povinnost vybavit vojáky prostředkem Xn. V řetězci těchto prostředků můžeme postupovat podle toho, jak vojáky vzdalují od bitevního pole a poskytují jim stále větší ochranu. Pokud existuje prostředek, který je „vzdálí zcela“ tím, že je plně nahradí, potom jako společnosti máme povinnost vojákům tento prostředek poskytnout. A jsou-li tímto nástrojem vojenští roboti (a neexistují-li silné důvody proti jejich využívání, viz další sekce), nejen že smíme, ale vlastně máme i povinnost vyplývající z kontraktuálního vztahu mezi námi a vojáky armádu plně autonomními vojenskými roboty vybavit a umožnit jejich využívání.

Druhý argument je sice situovaný do kontextu revizionistického paradigmatu spravedlivé války, ale lze ho chápat jako v tomto kontextu platnou variantu argumentu předchozího. Revizionistická teorie spravedlivé války vychází z etiky individuální sebeobrany, kde musíme rozlišovat dvě normativně odlišné situace: agresor útočí (a nemá právo zaútočit ani vést nějaké údery), obránce se brání (a má právo se bránit). Z této asymetrie (jeden nemá právo útočit, druhý má právo se bránit) také plyne, že obránce má právo volit co nejefektivnější formu sebeobrany (v mezích proporcionality), která ho ochrání před újmou na zdraví či dokonce životě. Je-li jeho život ohrožený, může použít pistoli, i když její použití vytváří asymetrii (útočník má nůž, který lze použít jen zblízka, pistoli je možné použít na dálku).

Něco podobného platí i v případě války. Představme si opět posádku bránící město proti útoku agresora. Mezi útočícími a bránícími vojáky existuje normativní asymetrie: první z nich nespravedlivě ohrožují zdraví a životy druhých, druzí se legitimně brání. Mají tedy právo na všechny prostředky, které jim poskytnou co nejefektivnější ochranu zdraví i života, a to i v případě, kdyby tím vznikla asymetrie. Mají-li útočníci jen pušky a obránci děla, obránci mají právo použít děla, i když je tím tento konflikt výrazně asymetrický a nakloněný v neprospěch útočníků. Obrana samozřejmě musí být v mezích pravidel ius in bello, například nutnosti: lze-li útok zastavit méně drastickým způsobem, který zvýší rizika pro posádku města, je třeba zvolit tento způsob.

A opět můžeme uplatit stejnou úvahu: pokud existují prostředky X1, ..., Xn, které poskytují bránícím vojákům ochranu před zraněním či smrtí, a je-li Xn prostředkem nejefektivnějším (v souladu s principy ius in bello), mají vojáci právo ho využít. A stejně jako v předchozím scénáři, jsou-li tímto nástrojem vojenští roboti, mají vojáci právo je využít a „poslat je bojovat namísto sebe“. Tyto dva argumenty se od sebe liší v tom, že první klade důraz na kontraktualistické povinnosti společnosti vůči armádě a jejím příslušníkům, ten druhý zase na individuální práva vojáků. V obou případech ale docházejí ke stejnému závěru: pokud plně autonomní letální vojenští roboti splňují podmínky ius in bello (a nemáme jiné silné důvody proti jejich využívání), je povinností společnosti armádu těmito stroji vybavit a individuálním právem každého vojáka nechat se těmito stroji v rámci možností zastoupit.

Argumenty proti využívání vojenských robotů

V této sekci představím dva dle mého soudu nejdůležitější argumenty proti využívání vojenských robotů. Další argumenty nechám stranou, protože je nepovažuji za tolik důležité. Odpůrci využívání vojenských robotů například tvrdí, že tyto stroje nebudou schopné dodržovat principy ius in bello, zvláště princip požadující rozlišování mezi legitimními a nelegitimními cíli. K tomuto argumenty podotknu dvě věci. Samozřejmě, pokud by vojenští roboti vůbec nebyli schopní dodržovat podmínky spravedlivého vedení války, je jejich nasazování ve válečných konfliktech vcelku triviálně vyloučeno z úvahy. Nicméně tak jednoznačné to být nemusí. Zvláště díky pokrokům v oblasti AI, strojového učení, rozpoznávání objektů apod. lze očekávat, že stroje zvládnou to samé, co lidé, zřejmě to zvládnou i lépe. V takovém případě je třeba neposuzovat možné selhání vojenského robota izolovaně, ale v celkovém kontextu. Musíme se jinými slovy ptát: pokud stroje někdy selhávají, vedou si celkově lépe než lidé, nebo hůře. A vedou-li si lépe, musíme jejich nasazení namísto lidí chápat jako morální pokrok. Proti využívání vojenských robotů se také často uvádí, že nad nimi není možné mít smysluplnou lidskou kontrolu. Není ale vždy jasné, v čem přesně by tato kontrola měla spočívat. A především, tento argument není vlastně platný jen v případě vojenských robotů. Plnou kontrolu nemáme ani nad tím, kam přesně dopadnou bomby shazované z letadel, koho zasáhne kulka z naší zbraně či kdy přesně vybuchne moderní inteligentní mina. Necháme-li stranou přehnané sci-fi scénáře o vojenských robotech, kteří se vymkli kontrole a likvidují vše kolem sebe, nesmíme mít nerealistická a od reality vojenských konfliktů vzdálená očekávání. Úplnou kontrolu lze získat velmi těžko, v praxi bude stačit, když vojenští roboti budou plnit své úkoly a budou v tom i dodržování principů spravedlivé války lepší než lidé (nad nimiž mimochodem také nemáme úplnou kontrolu).

Zmíním zde ještě jeden argument proti nasazování vojenských robotů, který operuje s odpovědností za újmu. Když selže nějaký velitel či voják – a dopustí se třeba válečného zločinu –, existuje někdo, komu je smysluplné přisoudit morální odpovědnost. Nemusí být vždy jednoduché viníka identifikovat, nicméně snaha o jeho identifikaci je smysluplná, protože lidé jsou za své jednání odpovědní (nebo si to alespoň myslíme). Představme si ale, že nějaký vojenský robot špatně identifikuje cíl a zabije civilistu. Kdo ponese odpovědnost za jeho smrt? Tento argument operující pojmem odpovědnosti (či její nepřítomnosti) bývá často vznášený jako vážný argument proti využívání vojenských robotů, já si ale myslím, že tak vážný není. V některých případech nebude těžké určit, kdo nese odpovědnost. Daného robota například lze nasadit pouze za dobré viditelnosti, velitel ho však „poslat do boje“ v nevhodných světelných podmínkách; odpovědnost bude jeho. Ale musíme se smířit s tím, že někdy nenajdeme nikoho, kdo by odpovědnost nesl; robot prostě udělal chybu (jeho software není bezchybný) a neexistuje nikdo, kdo by za to byl zodpovědný. Může to znít paradoxně, ale až tak paradoxní to není. Například i u autonomních vozidel se uvažuje o tom, že za některé jeho volby nebude mít nikdo odpovědnost ve smyslu viny. Jedinou odpovědností bude tzv. odpovědnost objektivní za vzniklou škodu. Podobně to může být v případě vojenských robotů a zabitého civilisty: nemusí existovat nikdo, kdo by nesl subjektivní odpovědnost (vinu), ale je zde újma (smrt) a měl by být určený nějaký subjekt (armáda, stát), který poskytne kompenzaci.

Mnozí odpůrci vojenských robotů používají – dle mého soudu překvapivě – často argument opírající se o lidskou důstojnost. Může mít například následující podobu: vojáci jsou lidé a uvědomují si, že lidský život je cenný. Je jim také jasné, že rozhodnutí vzít někomu život je jedno z nejvážnějších rozhodnutí v jejich životě, stejně jako míru újmy, která je s jejich rozhodnutím spojena. Jsou to morální aktéři, mají svou morálku, ale i emoce a odpovědnost. Volba zabít není jednoduchá a vyžaduje nějakou míru reflexe a uvědomění, které vychází i z vlastního pochopení svého lidství, křehkosti a vážnosti smrti. Stroje nic z toho nemají, nejsou morální aktéři, nejsou schopní morální rozvahy, nemají emoce a nenesou za své jednání odpovědnost. Zatímco zabití nepřátelského vojáka jiným vojákem nemusí být (z výše uvedených důvodů) v rozporu s lidskou důstojností, zabití strojem s ní v rozporu je. A vzhledem k důležitosti lidské důstojnosti v našem sebepojetí a také v rovině hodnot a normativních úvah bychom neměli dopustit využívání nástrojů ničení, které svým jednáním lidskou důstojnost pošlapávají.

Jak jsem napsal, považuji argumenty využívající pojem důstojnosti za poněkud překvapivé a nepříliš přesvědčivé. V roce 2002 se před Výborem pro lidská práva OSN uzavřel pozoruhodný soudní proces, který započal o několik let dříve ve Francii. Jeho protagonistou byla lidská důstojnost a její porušování. V listopadu 1991 vydal starosta francouzského města Morsang-sur-Orge nařízení zakazující házení trpaslíky. Mělo se jednat o kratochvíli spočívající v házení „trpaslíky“, tedy lidmi trpícími diastrofickým dwarfismem, vrozenou poruchou enchondrální osifikace. Přesněji řečeno, oním „trpaslíkem“ byl M. Wackenheim, jehož měli účastníci soutěže házet na nafukovací matraci. Prazvláštní druh zábavy, nepochybně. Wackenheim ji však považoval za zdroj obživy, a tak se proti zákazu odvolal. V únoru 1992 mu dal Správní soud ve Versailles zapravdu a starostův zákaz zrušil. Spor tím však neskončil a doputoval ke Conseil d’État, nejvyššímu správnímu soudu Francie, jenž se postavil na stranu starosty rozhodnutí soudu nižší instance zrušil.

Jaký měl ale starosta důvodu vstupovat do (nepříliš vkusné) lidové zábavy? Odpovědí je lidská důstojnost, přesněji řečeno, starostovo chápání lidské důstojnosti a podmínek jejího narušování. Domníval se, že házení „trpaslíky“ představuje porušení respektu k lidské důstojnosti. A Conseil d’État mu v tom dal plně zapravdu. Wackenheim se však nevzdával a odvolal se k Výboru pro lidská práva OSN. Jádrem jeho argumentace byla také lidská důstojnost. Uváděl, že soutěž v házení „trpaslíků“ žádným způsobem jeho důstojnost nepo-rušuje, starostův zákaz však ano, neboť mu brání v tom, aby si svobodně zvolil způsob výdělku. Argumenty však nenarazily na úrodnou půdu, a tak v červenci 2002 celá kauza dospěla ke konci. Důstojnost, jak ji chápal starosta Morsang-sur-Orge a soudci vyšších soudních instancí, zvítězila, důstojnost, jak ji vnímal a prožíval dotčený, jehož se zákaz a rozsudky bezprostředně týkaly, prohrála.

Tento zajímavý soudní proces velmi dobře ilustruje obtíže spojené s lidskou důstojností. Jedná se o pojem s nejasně definovaným obsahem. To ostatně dosvědčuje i jazyková praxe. Běžně hovoříme o důstojnosti jednání („choval se tam nedůstojně“), nebo o důstojnosti spojenou s nějakým úřadem („důstojnost ústavního soudce“). Jazykem lidské důstojnosti posuzujeme chování reprezentantů nějakých rolí qua reprezentantů těchto rolí („nechoval se tam důstojně jako prezident ČR“), ale také podmínky, když například říkáme, že někdo musel vyrůstat v nedůstojných podmínkách. V lidskoprávních dokumentech figuruje důstojnost vykládaná jako jakási inherentní vlastnost lidských bytostí, jež představuje základ lidských práv. Je možné v těchto příkladech využívání slova „důstojnost“ nalézt nějaké spojující prvky? Je „důstojnost“ analogickým pojmem, který má nějaký primární analogát a všechny ostatní významy čerpají svou určitost z něj?

Nepopírám, že existují snahy pojem důstojnosti „zachránit“ a dát mu jasný obsah. Tvrdím ale, že nemáme k dispozici dostatečně dobře propracované a odůvodněná mechanismy odvozování hodnotových a normativních závěrů z tohoto pojmu. Je „házení trpaslíky“ v rozporu s jejich důstojností? A ztráta obživy není? Ilustrativní je diskuse o eutanazii: oba tábory (zastánci i odpůrci) časti opracují s pojmem důstojnosti. Zastánci eutanazie hovoří o důstojné smrti, právu na důstojný odchod ze života, tvrdí, že limitovat autonomii pacientů zákazem eutanazie je v rozporu s jejich autonomií. A odpůrci eutanazie zase tvrdí, že důstojná smrt je smrt přirozená, v důstojném prostředí a případně s tišením bolesti, utrpení či úzkosti, a zabití pacientů lékařem označují za v rozporu s jejich důstojností.

Argumenty z důstojnosti lze navíc obrátit. Někdo může tvrdit, že když vojáka X zabije voják Y, může to být v souladu s důstojností X. Ale co když je Y v depresi, stresu, hnán touhou po pomstě? Dokážeme efektivně rozlišit důstojné zabití od nedůstojného? Možná bychom mohli říci, že podmínky důstojného zabití představují ideál, jemuž by měli vojáci dostát. Jenže to je v rozporu s jejich výcvikem, zvláště s různými formami dehumanizace oponenta, které mají uchránit psychiku vojáků a usnadnit jim plnit bojové úkoly. Možná se jedná o ideál, který vypadá dobře na papíře, ale vůbec neodpovídá realitě války. Kromě toho, zastánce využívání robotů se může ptát, zda není víc v rozporu s lidskou důstojností existovat po nějakou dobou v děsivých podmínkách, špíně, sledovat své přátelé a spolubojovníky, jak umírají a být nuceni zabíjet, často velmi brutálním způsobem. Vojenští roboti mohou znamenat, že v těchto podmínkách bude muset být méně vojáků, méně jich bude muset čelit stresu, ohrožení vlastního zdraví a života, nutnosti zabíjet a samozřejmě všem následkům, které si z toho přinesou. A je-li tomu tak, potom jsou body opět na straně vojenských robotů.

Poslední argument proti vojenským robotům spadají do oblasti ius ad bellum. Teorie spravedlivé války je realistická a vyhýbá se dvěma extrémům – pacifismu a realismu. Vychází z uvědomění, že války se bohužel vedly, vedou a povedou, snaží se ale nastavit podmínky tak, aby státy nevstupovaly do válek neuváženě a, když už ve válce jsou, aby minimalizovaly utrpení dodržováním podmínek vedení války. V souvislosti s vojenskými roboty bývají vznášeny dvě související námitky: povedou k novému závodu ve zbrojení a usnadní války (jejich počet vzroste).

Zvláště demokratické státy mají často velmi silné důvody nezačít válku: ve válce umírají jejich obyvatelé. Nejsou to ale abstraktní položky na seznamu ztrát, nýbrž konkrétní lidé, kteří mají své rodiny, přátelé a známé, kolegy a společenství, v nichž žijí své životy. Nevole lidé, neochota podstupovat rizika, přicházet o drahé a známé, bývá silným faktorem, které si státy musí dobře zvážit, než se rozhodnou vstoupit do války. A – například v případě US a dalších demokratických zemí – i faktorem, který může rozhodnout o ukončení války, která již probíhá. Představme si ale, že vojáci jsou výraznou měrou nahrazeni roboty. Ti nemají rodiny, blízké ani známé; jsou to jen stroje (i když i k nim lidé chovají silné vztahy). Faktor, který zcela zásadně ovlivňuje rozvahu, zda vstoupit do válečného konfliktu, by mohl být zcela či alespoň do dostatečné míry ze hry. Bude proto válek více? A pokud ano, neznamená to, že možné benefity spojené s využíváním vojenských robotů budou převáženy právě tím, že válek bude více?

Osobně tuto úvahu považuji za velmi důležitou a odpověď na obavu, již vznáší, ze sice realistickou, ale nepříliš uspokojivou. Jinými slovy, riziko zmnožení válečných konfliktů díky nahrazování vojáků roboty považuji za reálné (byť nedokážu říci, jak moc reálné je), existuje však na něj odpověď, která je sice přesvědčivá, ale z etického hlediska nepříliš uspokojivá.

Řekněme, že všichni souhlasíme s tím, že nasazování vojenských robotů povede (kromě závodu ve zbrojení) k tomu, že vstup do války bude pro státy snazší; důsledkem bude více válek. A můžeme také předpokládat, že žádný stát to nepovažuje za dobrý výsledek; každý rozumný a morální stát si musí přát, aby válek bylo méně. Když se vžijeme do situace nějakého konkrétního státu, mohl by uvažovat následovně: ideální by bylo, kdy nikdo z nás vojenské roboty nevyvíjel a nepoužíval (ideální z pohledu frekvence válek). Neexistuje ale žádná garance, že žádný stát je vyvíjet a využívat nebude. Vojenští roboti nepochybně představují strategickou výhodu a nejhorší, co se mi může stát je stav světa, kdy já roboty nevyvíjím, ale ostatní (všichni či někteří) je vyvíjejí. Vzhledem k tomu je sice pro nás všechny nevýhodné roboty vyvíjet (protože to může znamenat více válek), nicméně nic jiného mi nezbývá. Situace „nikdo roboty nevyvíjí“ je ideálem, který ale neumíme zaručit. A situace „já je nevyvíjím, ale ostatní ano“ je pro mě katastrofální. Je proto třeba být realisty a roboty vyvíjet. A to i když si uvědomuji, že stejnou úvahou se budu řídit další státy a výsledkem budou závody ve zbrojení a častější války.

Netvrdím, že toto dilema dokazuje, že závody ve zbrojení a častější války jsou nevyhnutelné. Myslím si ale, že úvahy o rozumnosti vyvíjet či nevyvíjet vojenské roboty v situaci, kdy jejich zákaz nelze efektivně vynutit, jsou vcelku realistické a vrhají alespoň nějaké světlo na to, proč nelze očekávat, že by se nějaký stát tohoto vědeckotechnického vývoje vzdal. A jak jsem napsal, je to realistické (státy prostě roboty vyvíjet budou), je to individuálně rozumné (pro nějaký stát by byla katastrofa, kdyby se vývoje vojenských robotů vzdal, když jiné na nich pracují a chtějí je využívat), ale eticky nešťastné (vyplní-li se prognózy a využívání robotů frekvenci válek zvýší). Nic to ale nemění na platnosti argumentů ve prospěch vojenských robotů. Ideální by bylo, kdyby žádný stát neměl armádu a války vůbec nebyly. Realita je ale jiná; a některé války jsou spravedlivé a jiné nespravedlivé, některé metody vedení války jsou nesprávné a jiné v souladu s principy spravedlivé války. Podobně lze asi říci, že by bylo ideální, kdyby vojenští roboti neexistovali. Ale existují; a mají potenciál učinit vedení válek humánnějším.

Literatura

Arkin, R. Governing Lethal Behavior in Autonomous Robots. Boca Raton, FL: CRC Press, 2009.

Bhuta, N., et al. (eds.). Autonomous Weapons Systems. Law, Ethics, Policy. Cambridge: Cambridge University Press, 2016.

Dobos. N. Ethics, Security, and the War-Machine. The True Cost of the Military. Oxford: Oxford University Press, 2020.

Galliott, J. Military Robots: Mapping the Moral Landscape. Surrey, UK: Ashgate, 2015.

Galliott, J., MacIntosh, D., Ohlin D. J. (eds.). Lethal Autonomous Weapons. Re-Examining the Law and Ethics of Robotic Warfare. New York: Oxford University Press, 2021.

Hammes, T. X. The Sling and the Stone. In War in the 21th Century. St. Paul: Zenith Press, 2006.

Leveringhaus, A. Ethics and Autonomous Weapons. London: Palgrave Macmillan, 2016.

Lucas, G. Law, Ethics, and Emerging Military Technologies. New York: Routledge, 2023.

Petraeus, D., Roberts, A. Conflict. The Evolution of Warfare from 1945 to Gaza. London: William Collins, 2023.

Scharre, P. Army of None. Autonomous Weapons and the Future of War. New York and London: W. W. Norton & Company, 2018.

Singer, P. W. Wired for War. The Robotics Revolution and 21st Century Conflict. London: Penguin, 2009.

Report je ke stažení zde.

Umělá inteligence jako zdviž do naší budoucnosti

Jiří Wiedermann, Jan van Leeuwen

zde.Co to je: je to moudré, ale není to živé? Přesně taková entita se v poslední době objevila mezi námi. Nikdo neví, jak vypadá, jestli má tělo, nějaké smysly, je inteligentní. Jediné, co víme, je, že údajně sídlí na „výpočetním oblaku“. Ale všem, kteří se s ní stýkali anebo aspoň o ní slyšeli, je zcela jasné, že se s ní dá dorozumět mnoha jazyky, lze s ní rozumně konverzovat v podstatě na jakékoliv téma, v drtivé většině konverzaci dobře rozumí, smysluplně argumentuje, ale bohužel si občas vymýšlí a lže. Samozřejmě, řeč je o generativní umělé inteligenci. Její vlastnosti jsou tak zajímavé a rozporuplné, že debata o ní přitáhla pozornost laické i odborné veřejnosti a ovládla velkou část mediálního prostoru. Odborníci z oblasti umělé inteligence, neurovědci, filozofové, kognitivní vědci, jazykovědci, význačné osobnosti byznysu, a intelektuálové se přou, jestli není nebezpečná pro lidstvo, jak moc je užitečná, jestli má nějaké mentální vlastnosti srovnatelné s lidskými, a jestli vůbec, či za jakých podmínek, ji dále rozvíjet. Máme se s ní bratříčkovat, obejmout ji, kultivovat, rozvíjet ji, spolupracovat s ní, anebo naopak, stranit se jí, zakazovat ji, bát se ji a nepokoušet se ji zvelebovat?

Pokud tedy odborná i laická veřejnost pochybuje o tom, jestli jsou pro nás zatím tušené možnosti umělé inteligence potenciálně nebezpečné, má jistě smysl ptát se,

„Proč vlastně rozvíjíme umělou inteligenci?“, resp.

„Jaký účel má používání umělé inteligence?“

Odpovědi na takové otázky jsou jednoduché, pokud se ptáme na konkrétní vývoj a smysl systémů umělé inteligence, které řeší nějaké konkrétní a známé problémy. Pokud se ale jedná o umělou inteligenci, které bude obecná v tom smyslu, že dovede řešit jakýkoliv problém a dělat vlastní rozhodnutí, je odpověď složitější. V tomto případě nás zajímají odpovědi na naše dvě otázky, vycházející z hlubšího pochopení pojmu umělé inteligence a jejího dosavadního vývoje. Tyto by měly vyplývat z nějakého konceptu, jež platí pro „jakoukoli umělou inteligenci“, přinesou nové vhledy do povahy umělé inteligence a dovolí extrapolaci trendů v oblasti umělé inteligence, a tím pádem umožní racionální představy o budoucnosti umělé inteligence. Pod pojmem „jakákoliv umělá inteligence“ rozumíme jak to, co v současné době považujeme za umělou inteligenci, tak i veškeré druhy uměle vytvořené inteligence v budoucnosti, jak na Zemi, tak kdekoliv ve Vesmíru.

Chceme, aby nám naše odpovědi na výše uvedené odpovědi umožnily zjistit, kam se bude umělá inteligence ubírat. Jak ale můžeme určit, kam umělá inteligence směřuje? Můžeme identifikovat žádoucí směr dalšího vývoje, který je podložen důkazy? Jaké důsledky bude mít pro naši budoucnost? Existují nějaké překážky, kterým se musíme vyhnout?

Přesvědčivé argumenty k zodpovězení takových „dílčích otázek“ lze uvést pouze tehdy, jsou-li podloženy nepřehlédnutelnými fakty. Proto se naše argumentační linie budou opírat o historické a současné trendy v informačních technologiích, konkrétně v umělé inteligenci, a také o filozofické úvahy a částečně o formální teorii. To nám pomůže vysledovat objektivní povahu problému a v tomto rámci navrhnout nejen dobře podložené odpovědi, ale také extrapolaci významu rozvoje umělé inteligence pro naši budoucnost.

Ukážeme, že budoucí umělá inteligence se bude kvalitativně lišit od té současné tím, že bude využívat znalosti a zkušenosti k účelnému jednání. To propůjčí systémům umělé inteligence novou pokročilou schopnost, kterou lze shrnout pod pojem umělé moudrosti. V kontextu systémů AI je umělá moudrost novým pojmem, který zvýší schopnost budoucích systémů vyrovnat se se složitostí, proměnlivostí a nejednoznačností reálného světa, které tradiční systémy nebyly schopny. Příslušné systémy budou mít schopnost učit se v průběhu času, přizpůsobovat se, řešit složité problémy a samostatně se rozhodovat. V neposlední řadě budou schopny činit etická rozhodnutí.

Z toho dále odvodíme vizi budoucí umělé inteligence, která se řídí umělou moudrostí a která je přitažlivá, věrohodná a bezpečná. Vysvětlíme, proč a jak lze takovou AI považovat za výtah do naší budoucnosti a za jakých okolností se jí nebudeme muset bát.

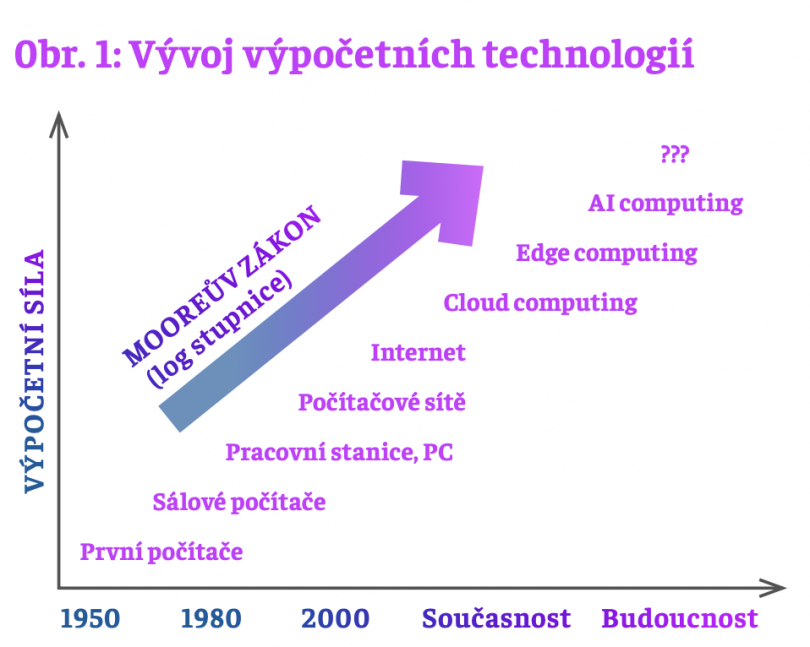

Trendy ve využívání výpočetních technologií

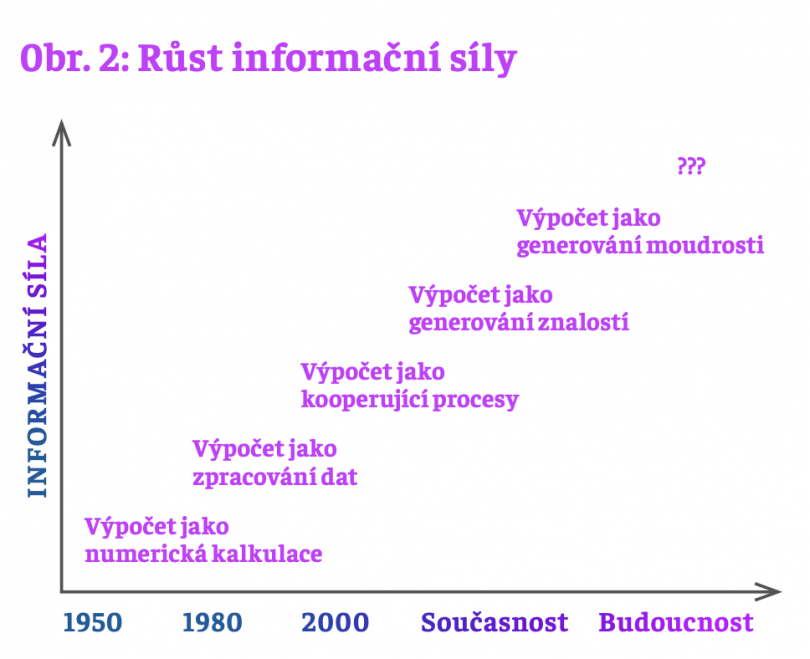

Pro identifikaci trendů v oblasti umělé inteligence budeme vycházet z trendů rozvoje výpočetních technologií od jejich počátků zhruba v polovině 20. století až po současnost. Přehledně jej zachycuje obr. 1. Zde vidíme, jak výpočetní síla počítačů průběžně exponenciálně rostla v souladu s Mooreovým zákonem a jak se měnily odpovídající výpočetní prostředky a paradigmata.

Z hlediska této kapitoly je však zajímavější pohled na předchozí výpočetní technologie zachycující proměnu typu zpracovávaných dat, a jejich způsobu zpracování, v závislosti

na nárůstu výpočetní síly, zachycený na obr. 2. Z obou obrázků je jasně vidět, jak s rozvojem informačních technologií a jejich aplikací rostla (a roste) jejich informační síla v rámci tzv. DIKW hierarchie: data, informace, znalosti, moudrost. Tato hierarchie zachycuje skutečnost, že v typickém případě je informace definovaná pomocí dat, znalosti pomocí informací, a moudrost pomocí znalostí.

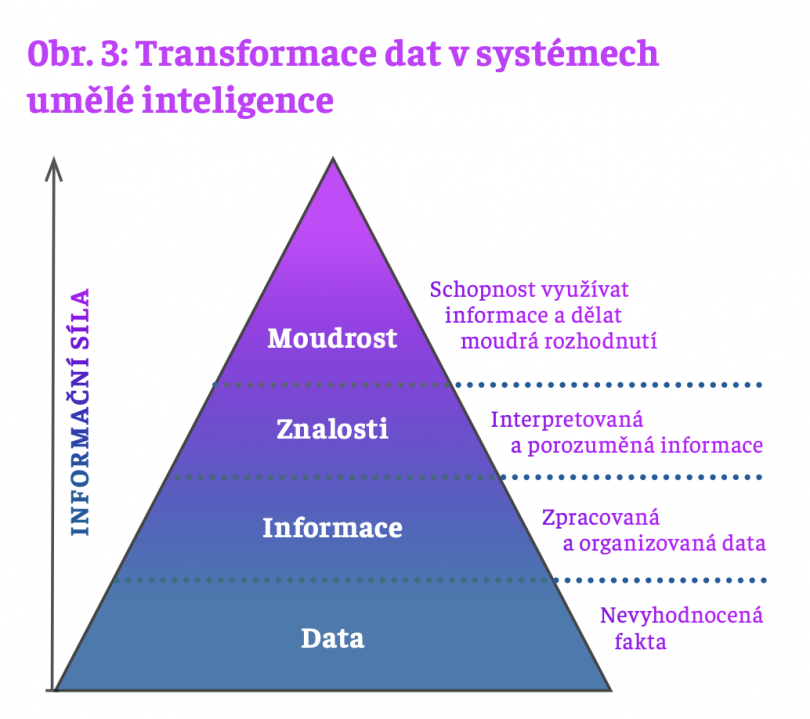

Pojem DIKW hierarchie popularizoval v r. 1988 Russell Ackoff ve své prezidentské přímluvě k Mezinárodní společnosti pro systémové vědy. Nicméně, tato myšlenka se v různých podobách objevovala již dříve mezi odborníky zabývajícími se počítači, řízením a operačním výzkumem, a proto ji lze považovat za „lidovou moudrost“. Tato hierarchie se často zobrazuje jako pyramida postavená na datech a s moudrostí

ve vrcholu. Tvar pyramidy zachycuje fakt, že moudrost je nejvyšší formou znalostí, které je možné dosáhnout pouze na základě dat, které se transformují postupně přes informace a znalosti až na moudrost. To je znázorněno na obr. 3.

Není to vlastně nic jiného než hrubý nárys architektury systému pro zpracování dat. V jednotlivých obdélnících přilehlých k pyramidě je naznačeno, co je předmětem zpracování dat, ve směru zdola nahoru, na dané úrovni. Transformace dat mezi jednotlivými úrovněmi pyramidy se děje pomocí algoritmů, často velmi složitých (např. neuronové sítě, statistické výpočty, rozeznávání vzorů, identifikace trendů atp.), které závisí na požadovaném výsledku transformace a druhu dat vstupujícím a vystupujícím z procesu transformace. Přesněji, data vstupující do pyramidy mohou být čísla, texty, kódy, obrázky, výstupy různých senzorů, či jiná nevyhodnocená fakta. Zpracování na informační úrovni může zahrnovat statistické výpočty, rozeznávání vzorů, trendů apod. Ještě na vyšší úrovni znalostí jde o budování konceptů, odhalování zákonitostí a nacházení vztahů mezi různými skupinami informací. Konečně na úrovni moudrosti se hledají možnosti cílevědomé aplikace znalostí na nové situace. Zde přicházejí k slovu např. neuronové sítě imitující naše představy o práci mozku.

Kvalitativní rozdíl mezi daty na dvou přilehlých úrovních představuje míru porozumění datům na nižší úrovni, vyjádřené prostředky vyšší úrovně, vždy vzhledem k poslání příslušného systému. Je zřejmé, že taková míra porozumění roste ve směru zdola nahoru.

Uvedené schéma je velmi obecné, platí pro jakýkoliv systém umělé nebo přirozené inteligence, jenž generuje moudrost, bez ohledu na to, v jakém prostředí pracuje a jaké je jeho poslání. Platí to třeba pro automatické dveře, samo-řiditelné auto, autonomní systém řízení protiraketové obrany, pro systémy generativní umělé inteligence, pro mozek, dokonce i pro tzv. „superinteligenci“. Na této úrovni abstrakce je schéma práce takových systému stejná.

Podle Ackoffa, první tři úrovně hierarchie lze „programovat“ a tudíž automatizovat, kdežto poslední, čtvrtou úroveň, nikoliv, protože moudrost obsahuje i etické a morální aspekty, které nelze svázat žádnými jednotnými pravidly, protože závisí na rozhodnutích zájmových stran, které ovlivňují a realizují proces transformace dat, ale nikoliv produkt.

„…usuzuji, že člověk nikdy nebude moci svěřit automatům úlohu systémů generujících moudrost. Může se klidně stát, že moudrost, která je nezbytná pro účinné hledáni ideálů, a samotné jejich dosahování, jsou vlastnosti, které odlišují člověka od strojů.“

Pravdivost tohoto tvrzení velmi závisí na tom, co v kontextu umělé inteligence budeme považovat za moudrost. Existuje rozumná definice moudrosti, která se bude dát realizovat výpočetně, a tedy, svěřit strojům? Jak se díváme na Ackoffovo tvrzení ve světle současných trendů v rozvoji umělé inteligence? To uvidíme v dalších částech.

Od dat k moudrosti

V dalším budeme uvažovat systémy umělé inteligence ve formě vtělených kognitivních agentů. Jsou to fyzické entity, které mohou nepřetržitě vnímat své okolí, učit se ze své zkušenosti, předvídat běh událostí, jednat účelně a eticky pro splnění svých cílů a přizpůsobovat se měnícím okolnostem.

Pokud chceme porozumět práci konkrétního agenta, tak nás zajímá, s jakými daty a informacemi agent pracuje, jaké znalosti využívá, a na co je určeno „moudro“, které generuje. Pro tento účel se ukazuje jako vhodné dívat se na schéma z obr. 3 z perspektivy tzv. znalostní teorie výpočtů, vyvinuté před několika lety autory této práce. Tento pohled má tu výhodu, že přímo pracuje s pojmy užívanými v definici DKIW pyramidy, a tak jak postupuje transformace dat v této pyramidě, tyto pojmy vlastně výpočetně definuje. Z hlediska této teorie nahlížíme totiž na výpočty jako na výpočetní procesy, které generují znalosti a moudrost z informací nad danou znalostní doménou D pomocí dané znalostní teorie T.

Znalostní doména je souhrn informací o objektech, faktech, procesech reálného světa, které jsou předmětem zájmu agenta. Prvky znalostní domény tvoří podmnožinu reálného světa. Informace ze znalostní domény jsou systému dodány z části zvenčí a zčásti je získává ze svých vstupních dat, které načítají příslušné senzory. Načtením dat daným senzorem se data stávají informacemi takového typu, pro jaký je senzor určen. Tento typ dat musí souhlasit s typem informací, které tvoří znalostní doménu.

Výpočet dále pracuje tak, že kombinuje prvky znalostní domény – jimiž jsou již zmíněná informace (resp. jejich reprezentace), nazývané také elementární znalosti do odvozených, často složitějších konstrukcí, které již tvoří novou znalost, opět nad danou doménou a v rámci teorie T. Tato fáze zpracování odpovídá třetí úrovni DIKW pyramidy.

Pro kombinaci prvků této úrovně používá výpočet množinu (odvozovacích) pravidel, která může být předem daná v rámci teorie T, anebo se může tvořit pomocí učení během velkého počtu různých výpočtů nad danou doménou.

Systém tímto způsobem pracuje s více či méně formální teorii T, která zachycuje vlastnosti dané znalostní domény a způsoby odvozování nových znalostí, stále v rámci dané domény. Jakmile tedy systém načte nějaká data, tyto se stávají v rámci teorie T informací. Z nich systém shora popsaným způsobem generuje znalosti; některé z nich se jsou dále využívány na čtvrté úrovni pyramidy v rámci systému generování moudrého jednání (viz dále). Na této úrovni totiž vstupuje do hry, kromě transformace dat, další schopnost systémů umělé inteligence – a tím je jednání. V tomto smyslu je jednání cílená činnost systému směřující k naplnění jeho cílů, resp. poslání, pro které je systém zkonstruován, anebo se evolučně vyvinul.

Z hlediska znalostní teorie výpočtu považujeme za okolí systému (či agenta) tu část světa, kterou popisuje znalostní doména D. Řídícím systémem agenta je znalostní teorie T. Jaké jednání je považováno za účelné je definováno ve specifikaci poslání agenta. Specifikace poslání pro každou situaci určuje, jakou podmínku musí chování agenta dodržet, v závislosti na historii jeho předchozího jednání.

Proto je důležité si uvědomit, že specifikace poslání se nerovnají funkční specifikaci systému. Ty první určují, co má systém dělat, kdežto ty druhé, jak to má dělat.

Někteří agenti mohou mít speciální schopnost pro svoji činnost generovat a využívat speciální druh znalostí – (umělou) moudrost (Wiedermann & van Leeuwen, 2023). Moudrost se projevuje v jednání (chování) agentů, které za každých okolností naplňuje poslání systému.

Umělá moudrost agenta je jeho schopnost aplikovat své znalosti na jednání směřující za každých okolností k cílevědomému vytváření pragmatických hodnot, které je předepsáno v jeho specifikaci poslání, za současného dodržování etických hodnot.

Teď je jasné, proč se znalosti a moudrost nenacházejí na stejné úrovni v rámci DIKW hierarchie. Je tomu tak proto, že znalost je z pohledu znalostní teorie výpočtů výsledkem transformace dat a informací, tj. v podstatě je výsledkem jakéhokoliv výpočtu. Naproti tomu moudrost přináší do výpočtů specifickou formu zpracování znalostí nepřetržité cílevědomé a efektivní jednání (angl. agency) prostřednictvím synergetického efektu znalostí, kognice a jednání. Znalosti jako takové, samotné, představují pasivní formu znalostí, kdežto moudrost představuje jejich akční formu. Moudrost bez znalostí nemůže existovat.

Schopnost generovat umělou moudrost posouvá možnosti systémů umělé inteligence na kvalitativně vyšší úroveň v porovnání se systémy, které takovou schopnost nemají.

Tato schopnost agenta musí být popsaná v jeho znalostní teorii. Etika, resp. etické jednání může být popsané jako součást znalostní teorie anebo jako samostatná znalostní teorie. Moudrý agent tedy zaručeně za každých okolností vytváří pragmatické i etické hodnoty, specifikované v jeho poslání.

Formálně definovaná umělá moudrost umožňuje hovořit o moudrosti extrémně jednoduchých kognitivních systémů, jakým jsou např. automatické otvírané dveře. Jsou moudré, protože jednají tím způsobem, že otevřou dveře (vykonáním akce vytvoří pragmatickou hodnotu pro procházející osobu), kdykoliv rozeznají takovou potřebu (kognitivní schopnost), a chovají se eticky (pokud jsou zkonstruovány tak, že nikoho nepřivřou, a nic jiné se od nich nepožaduje. Složitější systém, jako třeba autonomní vozidlo, je také moudrý, protože (a pokud) pomocí kombinovaného efektu využití svých senzorů a motorů vytvoří pragmatickou a etickou hodnotu – doveze svého uživatele bezpečně k cíli.

V definici hierarchie DIKW se moudrost nachází v jejím vrcholu, což naznačuje, že nějaká „vyšší forma“ vědění neexistuje. Dokonce i tzv. „superinteligence“ je forma moudrosti. Moudrost se tak jeví jako ultimativní cíl umělé inteligence. Zde je na místě poznamenat, že takový cíl nelze dosáhnout v konečném čase. To dokazuje např. matematika, ve které existují nekonečné hierarchie různých znalostních teorií.

Definice umělé moudrosti je tedy ukotvená ve znalostní teorii výpočtů. To má důležité důsledek pro naše úvahy ze sekce 2, kde jsme korelovali pozorovaný nárůst „informační síly“ jednak jako vývojový trend v oblasti výpočetní technologie, a také jako proces charakterizující čtyři úrovně DIKW pyramidy (data, informace, znalosti, moudrost). Teď jsme ukázali, že všechny tyto úrovně jsou dosažitelná pomocí výpočtů.

Tento postřeh má dalekosáhlé důsledky. V následující části se podíváme na systémy umělé inteligence s potenciálem generovat umělou moudrost.

Velké jazykové modely: inteligence bez kognice

Existují již v současné době systémy umělé inteligence, které generují umělou modrost? Zatím ne, ale jistou představu o tom, jak by mohly systémy generující moudrost v budoucnosti vypadat, nám dávají současné velké jazykové modely jakými jsou model GPT fy OpenAI, PaLM modely fy Google, LLaMa modely fy Meta, apod. Tyto modely jsou součástí tzv. generativní umělé inteligence, která se učí vzory a struktury z příkladů, jak byla používaná minulá data. Tyto znalosti pak využívá pro interaktivní generování nových obsahů podobné kvality, jakou měly učící data, za účelem asistování uživatelům v jejich činnostech.

Z formálního hlediska, znalostní doménou velkých jazykových modelů je přirozený jazyk (či jazyky), znalostní teorie systému je implicitní model světa, popsaný v daném jazyce, jenž si systém buduje během své učící fáze, a etická teorie je libovolná znalostní teorie, která definuje jednání kompatibilní s představami strůjců systému.

Ukážeme, že tyto modely mají potenciál generovat umělou moudrost (Wiedermann & van Leeuwen, 2023). Toto tvrdíme i přesto, že je známé, že tyto modely jsou velmi křehké (náchylné ke katastrofickým selháním), nespolehlivé (schopné dodat nesprávnou anebo vymyšlenou informaci), příležitostně schopné dělat elementární logické chyby v uvažování anebo v jednoduchých počtech. Náš argument ve prospěch tohoto tvrzení vychází z paradigmatu málo užívaného v oblasti umělé inteligence, kybernetiky anebo robotiky, ale o to známějšího v kognitivních vědách: paradigma 4E kognice (Newen, De Bruin, Gallagher, 2018). Toto paradigma postuluje, že kognice není pouhým vnitřním, individuálním procesem, nýbrž se jedná o emergentní proces, jež vzniká interakcí mezi mozkem, tělem, okolím a sociálním kontextem. Zkratka 4E pochází z angličtiny a naznačuje, že kognice je vtělená, vnořená, vykonávaná, a rozšířená (embodied, embedded, enacted, extended) pomocí mimo-mozkových procesů a struktur.

Vtělenost znamená, že kognice je ukotvená v našich smyslech, tělech a fyzikální zkušenosti. Vnořenost hovoří o tom, že kognice je součástí našeho způsobu života. Vykonatelnost konstatuje, že kognice slouží cílevědomé akci v reálném světě. A konečně rozšířenost vidí kognitivní systém jako celek zahrnující i prostředí včetně dalších lidí, nástrojů a zařízení.

Zastánci 4E kognice argumentují, že shora uvedené čtyři atributy mají vztah k inteligenci systémů, které splnění příslušných atributů vykazují. Atributy 4E kognice nelze přímo aplikovat na velké jazykové systémy, už jenom proto, že tyto nemají tělo, smysly, anebo efektory. Nicméně, ve všech čtyřech případech atributů 4E kognice můžeme v kontextu takových systémů hovořit o nepřímé vtělenosti, nepřímé vnořenosti, nepřímé vykonatelnosti, a nepřímé rozšířenosti. Vlastnost „nepřímosti“ pramení z toho, že velké jazykové modely nemají kognitivní aparát, který by jim umožnil přímou interakci s prostředím. Jak jsme však zmínili výše, jejich znalostní teorie obsahuje implicitní model světa, který si systém extrahoval z popisů světa a jeho vlastností jakoby „z druhé ruky“, zprostředkovanými lidmi v písemných podkladech, ze kterých se model učil. Všimněme si, že v takovém případě jazykové modely nevnímají svět „tak, jak vypadá“, tj. tak, jako ho vnímáme my lidé, ale pouze (neboli přesně) tak, jak se o něm, včetně o umělé inteligenci, píše.

Nepřímá vtělenost, nepřímá vnořenost, nepřímá vykonatelnost, a nepřímá rozšiřitelnost jsou zcela odlišné atributy než ty, uvažované v klasickém případě 4E kognice. Avšak i tak můžeme v takovém případě usuzovat z jednání systému přinejmenším na jakousi iluzorní inteligenci, která nabízí iluzi inteligence vzhledem k danému prostředí, založenou na masivní agregaci dat z tohoto prostředí a výběru reakcí, jež závisejí

na současném i minulém kontextu jednání systému. V každém případě jde o jednání odtržené od reálné, bezprostřední kognice. (Mimochodem – tak jednají i lidé, pokud dospějí k rozhodnutí na základě „přemýšlení“.) Iluzorní inteligence je v mnoha případech lepší než žádná inteligence. Otázkou zůstává, jestli součástí takové iluzorní inteligence je i nějaká forma vědomí. Iluzorní vědomí? Úvahy, jestli velké jazykové modely mohou mít vědomí se začínají objevovat v pracích odborníků z oblasti filosofie i umělé inteligence.

Je třeba si uvědomit, že text, který velký jazykový model vygeneruje, je vlastně „umělá moudrost“. Sémantika textu, který model vygeneruje, představuje ony požadované pragmatické, resp. etické hodnoty, a posléze samotný výpočetní akt konstrukce odpovědi odpovídá (resp. měl by odpovídat) „cílevědomému používání znalostí modelu“. „Cílevědomé jednání“ je řízeno dotazem – model generuje text, který nejlépe souzní s odpovědí na daný dotaz.

V reakci na iluzorní inteligenci velkých jazykových modelů můžeme tedy hovořit o iluzorní moudrosti takových systémů. Iluzorní inteligence velkých jazykových modelů současně vysvětluje jejich náchylnost ke katastrofickým selháním, kdy vygenerují vymyšlené informace nebo dělají elementární logické chyby v uvažování. Je tomu tak proto, že odvozovací mechanizmus těchto systému je založen na statistice, nikoliv logice. Systém nemůže v každém případě generovat „pravdivé odpovědi“, protože nemá přístup k vnějšímu světu ani k jiným nezávislým zdrojům za účelem ověřování faktů. Systém může generovat pouze taková fakta, která nejsou ve sporu s jeho naučenými trénovacími daty. Zatím není jasné, jestli je toto tzv. „kecání“ velkých jazykových modelů jejich vlastností, kterou dokážeme pouze minimalizovat, avšak nikoliv zcela odstranit.

Umění se zeptat: jak dostat moudré odpovědi z velkých jazykových modelů

Jakou moudrost můžeme, alespoň v principu, dostat z velkých jazykových modelů? Odpověď na to je vlastně skrytá již v jejich názvu. Proč se velké jazykové modely jmenují tak, jak se jmenují? Čeho jsou to modely? Z předchozí sekce víme, že tyto obrovské modely jsou vlastně implicitní modely našeho světa, zachycené v přirozeném jazyce. Jsou trénované na gigantických množstvích textových dat, které obsahují informace o našem světě – fakta, informace, různé vzory, jazykové struktury a znalosti, a také vztahy mezi nimi. To jim pak umožní získat vědomosti, a dokonce (umělou) moudrost o vnějším světě a generovat text konzistentní s tím, co o něm vědí.

Uživatelé, tj. my – lidé, získáváme z nich tyto vědomosti pomocí dotazů, tzv. promptů. Je jisté, že čím přesnější dotaz, čím lépe formulovaný požadavek, tím přesnější a výstižnější odpověď systému můžeme očekávat. Abychom takové dotazy efektivně formulovali je dobré vědět, alespoň v hrubých rysech, jak velké jazykové modely fungují. To nám umožní při sestavování dotazů vycházet vstříc potřebám modelu a umožnit tak jeho efektivní odpovídání na dotazy. Za tím účelem uvedeme velmi zjednodušené vysvětlení jejich činnosti na vysoké úrovni, oproštěné od méně podstatných detailů.

Základní datová strukturu, nad kterou modely pracují, je obrovská síť. V jejích uzlech jsou uloženy informace o slovech a větách. Spojení mezi uzly reprezentují vztahy mezi uzly, které se budují pomocí učení. Na tuto síť můžeme pohlížet jako na analogii mozku: uzly jsou mozkové buňky – neurony, propojení mezi nimi odpovídají synapsím. V technických termínech se jedná o umělou neuronovou síť.

Neuronová síť se učí prostřednictvím čtení textů z internetu. Vztahy mezi slovy a větami jsou vyjádřeny pomocí spojení mezi uzly. Každému spojení je přiřazena jeho váha. Váhy jsou vektory, které charakterizují sémantické vlastnosti vztahů: reprezentují jejich sílu, druh a vlastnosti; budují se a modifikují v průběhu učení. Je to proces absorpce veškerých znalostí a moudra z knih a webových stránek.

Když už je neuronová síť naučená, může být systém požádán o odpověď na daný prompt. Systém generuje odpověď slovo za slovem, jedno po druhém. Generace každého dalšího slova závisí na celém promptu, a na částečné odpovědi, kterou systém do té doby vygeneroval, a samozřejmě i na tom, co se model naučil ze svých trénovacích dat. Za tím účelem model obsahuje veledůležitý mechanismus, který je srdcem jeho „inteligence“: mechanizmus pozornosti.

Tento mechanizmus slouží modelu pro výběr, predikci, soustředění se na slovo, které bude model jako další generovat. Jde o to, aby se vybralo takové další slovo, které přispěje k „správné“ odpovědi, která by z hlediska znalosti uložených v síti co možná nejlépe reagovala na daný prompt. Přitom se vynechají slova, která jsou pro tento účel nepodstatná. (Tato ostatní slova však mohou být důležitá z hlediska formulace gramaticky správné odpovědi.)

Mechanismus pozornosti je také realizován pomocí neuronové sítě. Pro svoji činnost využívá váhy mezi spojeními uzlů, které vyjadřují sílu (míru pravděpodobnosti výskytu) vztahu mezi slovy promptu a slovy částečné odpovědi. Mechanismus pozornosti pak vybere slovo, které se s velkou pravděpodobností „hodí“ k prodloužení již generované částečné odpovědi a také ke slovům z promptu. Tím se zabezpečí, že systém generuje sémanticky nejlépe odpovídající a gramaticky korektní odpověď.

Systém současně monitoruje celý proces sledováním míry podobnosti (opět pomocí vah) mezi promptem a doposud generovanou odpovědí. Začne-li tato míra klesat, systém „ví“, že negeneruje relevantní odpověď a vyzve pozornostní mechanizmus, aby zaměřil pozornost na jiné části promptu. Tento proces monitorování míry podobnosti a využívání pozornostního mechanismu se opakuje do té doby, než je vygenerovaná kompletní a smysluplná odpovídající odpověď.

Monitorování míry podobnosti a využívání pozornostního mechanismu je zásadní inovace, která stojí v pozadí úspěchu současné generativní umělé inteligence. Toho si nejsou vědomi ani někteří odborníci na IT, kteří se domnívají, že model má přístup ke všem trénovacím datům, ze kterých se učil, a může je použít k vyhledávání relevantních informací v obrovské databázi. Tak to samozřejmě není, velký jazykový systém pracuje s naučeným modelem znalostí o trénovacích datech a odhalenými vztahy mezi nimi. Jazykový model je daleko menší než jeho trénovací data. Na dotazy odpovídá konstrukcí zcela nových odpovědí.

Právě popsaný princip práce velkých jazykových systémů je známý už řadu let a lze jej považovat za výsledek matematické a inženýrské invence. Avšak skutečnost, že začíná skvěle fungovat až „ve velkém“, na úrovni masivních dat a s nasazením obrovské výpočetní síly, považují někteří experti na umělou inteligenci doslova za vědecký objev.

Z právě popsaného principu fungování takových modelů je zřejmé, že uživatel může ovlivňovat kvalitu jeho odpovědí jediným způsobem – a tím je formulace promptu. Proces zpřesňování formulace promptu za účelem získání co nejvýstižnější odpovědi se v angličtině jmenuje „prompt engineering“, což se dá přeložit jako „konstrukce nápovědy“, anebo jednoduše „nápověda“.

Účelem nápovědy je dodat modelu – přesněji jeho pozornostnímu mechanismu – výstižné a stručné výrazivo, jež umožní modelu lepší porozumění promptu a generování srozumitelné odpovědi. Jazyk promptu proto budiž jednoznačný a střízlivý pro dosažení objektivní reakce. Často pomůže, zmíníme-li v dotazu pojmy, o kterých předpokládáme, že by se mohly vyskytovat v odpovědi. Intuice, emoce a subjektivní zkušenost jsou další záležitosti, které můžeme uvést, pokud jsou to pro získání odpovědi relevantní faktory. V rámci promptu můžeme zmínit i etická dilemata, které bychom chtěli v kontextu promptu vyřešit, sociální aspekty apod. – zkrátka veškeré okolnosti, kterým by model v rámci své umělé moudrosti možná nemusel věnovat pozornost. To způsobí, že model se při konstrukci odpovědi soustředí i na tyto aspekty. Také je dobré specifikovat formát, formu a styl odpovědi – seznam zarážek, tabulka, úvaha, zdvořilá žádost, populární nebo odborný text, alternativy apod.

Nejlepší způsob, jak se naučit formulovat účinné prompty pro dosažení přesných a relevantních odpovědí, je nebát se experimentovat s jejich různou podobou.

V případě velkých jazykových modelů platí pro určité typy dotazů, že v dobře formulované otázce se často skrývá návod na její odpověď.

Poslední dobrá rada je položit stejnou otázku různým modelům se stejným obsahovým zaměřením. Je překvapivé, jak se mohou odpovědi lišit z hlediska jejich relevantnosti a srozumitelnosti, anebo do jaké míry se mohou shodovat.

Můžeme umělé inteligenci důvěřovat?

Co když nás umělá inteligence oklame, cíleně, kdyby byla za tímto účelem zkonstruovaná, anebo „nechtěně“, kdyby byla chyba v její konstrukci? V tom druhém případě hovoříme o nechtěných vedlejších efektech. To, samozřejmě, může napáchat velké škody. Někteří lidé – a často i odborníci na umělou inteligenci – dokonce varují, že neřízený rozvoj umělé inteligence může existenčně ohrozit přežití lidské civilizace. Je to pravda? Na jakých argumentech jsou taková tvrzení založena?

Skutečnost je totiž taková, že neexistuje efektivní postup (algoritmus), jež by pro jakýkoliv systém umělé inteligence rozhodnul, buď empiricky, na základě testování jeho chování, anebo teoreticky, na základě znalosti jeho popisu, zda bude za každých okolností bezpečný – v souladu s „lidskými hodnotami“.

Mezi takové hodnoty počítáme i nemožnost ohrožení našeho přežití. Důvod v prvním případě je banální – inteligentní systém v případě jeho testování by totiž mohl předstírat, že je „hodný chlapec“, ale potom by se už choval, jak se mu zlíbí. Ve druhém případě je důkaz shora uvedeného tvrzení hluboký poznatek z teorie vyčíslitelnosti, jehož idea pochází od samotného A.M. Turinga, „vynálezce“ moderních počítačů a vizionáře umělé inteligence.

To na první pohled vypadá beznadějně, a proto se zdá být rozumné, nepouštět se do konstrukce takových systémů. Podívejme se však na předchozí tvrzení podrobněji.

Toto tvrzení totiž neříká vůbec nic o tom, že pro libovolně daný systém umělé inteligence nemůže existovat důkaz, že systém bude za každých okolností bezpečný. Jinými slovy, může se klidně stát, že pro daný systém existuje důkaz, že je důvěryhodný, avšak tento důkaz bude „fungovat“ jen pro tento jeden systém. Jestli takový důkaz nalezneme záleží, kromě naší inteligence, na složitosti daného systému. Např. pro již zmiňované automatické dveře je to zřejmě možné, pro samořídící vozidlo pravděpodobně také. Ale co se složitějšími systémy, jakými jsou např. velké jazykové systémy, o super-inteligentních systémech ani nemluvě?

Zde se nám totiž staví do cesty další překážka, a tou je neprůhlednost takových systémů. Vzhledem k tomu že takové systémy se budují pomocí učení, což je stochastický, evoluční proces, my ani nevíme, proč přesně takové systémy v konkrétních případech fungují. Jsou to pro nás „černé skříňky“. Vzhledem k astronomickému počtu situací, ve kterých mají takové systémy fungovat, není možné specifikovat jejich chování za všech okolností, které se mohou vyskytnout. Tím pádem ani není možné předepsat, jak se mají chovat za všech okolností. Toto opět vypadá jako ultimativní argument proti vývoji obecných systémů umělé inteligence (AGI), anebo super-inteligentních systémů.

Beznadějnost úkolu „zkrotit“ umělou inteligenci vypadá jako očividná ještě i z následujícího uhlu pohledu. My – lidé, vládnoucí jistou inteligencí, jsme postaveni před úkol, najít mechanismus, jenž by zabránil, za každých okolností, daleko vyšším inteligencím vymknout se naším zájmům. Je to vůbec principiálně možné, aby „nižší inteligence“ v tomto smyslu usměrňovala, jaksi na dálku, do budoucna, chování „vyšší inteligence“? Známe v přírodě podobný případ?

Podle Ilyu Sutskevera, šéfa výzkumu fy OpenAI, jsou takovým případem děti-nemluvňata. Jejich rodiče, daleko inteligentnější entity než nemluvňata, se starají velmi intenzivně o své potomstvo. Takže to nějak jde, vštípit, imprintovat tuto povinnost, starat se o blaho nižší inteligence, do fungování inteligence vyšší. Naše neschopnost odhalení mechanismu, jenž je za takovým chováním, je obrovskou překážkou na cestě k všeobecné umělé inteligenci.

Pro uklidnění obav z existenčního ohrožení lidstva umělou inteligencí je potřebné si uvědomit, že současná umělá inteligence je tomu, aby nás existenčně ohrozila, na hony vzdálená. Jednoduše to nejde, protože může maximálně ovládnout mysl některých důvěřivých lidí, ale žádné zkázonosné stroje. Sama nekoná ani o ničem nerozhoduje. Namísto obav z umělé inteligence je nutné napřít naše osvětové úsilí na vysvětlování skutečných benefitů umělé inteligence, ve vztahu k našemu blahobytu, a informovat pravdivě o výzkumném úsilí v oblasti umělé inteligence orientovaném na řešení problému souladu umělé inteligence s lidskými zájmy. Je celkem možné, že jednou, v budoucnosti, takový úkol nám pomohou vyřešit samotné systémy umělé inteligence. To je další důvod pro výzkum, vývoj a používání takových systémů.

Jak to všechno dopadlo?

Vraťme se nyní k naším dvěma motivačním otázkám ze začátku reportu. Zvážením naších předchozích výsledků a úvah jsme dospěli k době zdůvodněným odpovědím, jaké jsme slibovali v jeho počátku:

Umělou inteligenci rozvíjíme za účelem tvoření a rozvíjení nástrojů pro generování umělé moudrosti.

Účelem používání umělé inteligence je generovat moudrá rozhodnutí a moudré chování pomocí vzájemné spolupráce mezi lidmi a automatickými prostředky.

Dobrovolně se vzdát takových nástrojů by bylo nerozumné. Je třeba hledat cesty, jak takové nástroje rozvíjet, s nimi nažívat a jak je bezpečně používat. Jedno řešení je nasnadě: spolupráce lidí s takovými systémy. Řešit problémy společně, ve vzájemné dohodě. Nedovolit jedné straně činit zásadní rozhodnutí bez konzultace s druhou stranou. Dávkovat rozvoj takových systémů jako v moderní teorii etapovitého kognitivního vývoje, která pojednává o povaze a rozvoji lidské inteligence postupným rozšiřováním znalostních domén. Nevyvíjet další, „vyšší“ verze moudrých systémů, pokud nebude jasné, že stávající verze jsou v souladu s našimi hodnotami. Ideu takové spolupráce dobře vystihuje rodičovská metafora: vztah lidí k umělé inteligenci by měl být jako vztah mezi rodiči a jejich dětmi: když jsou děti malé, starají se o ně, a vychovávají je rodiče; když jsou děti dospělé a rodiče staří, pečují o ně, a ctí je jejich potomci

Tímto způsobem se stane lidská a umělá inteligence neporazitelnou dvojicí, která umožní formování naší budoucnosti podle našich představ.

Je nutné si uvědomit, že na moudrost generovanou v rámci spolupráce mezi lidmi a umělou inteligencí musíme uplatňovat stejná kritéria jako na umělou moudrost z části 3: totiž aplikovat veškeré znalosti na jednání směřující k cílevědomému vytváření pragmatických hodnost pro kultivaci naší společné budoucnosti, za současného dodržování etických hodnot.

Z filozofického hlediska a z pohledu metodologie, umělá moudrost představuje kvalitativní posun ve výpočetním paradigmatu používaném v umělé inteligenci, a sice od pohledu na výpočty jako procesy generující znalosti směrem k procesům generujícím a využívajícím moudrost. Koncept umělé moudrosti, vedle lidské moudrosti, se stává novou, a pravděpodobně finální metou lidského snažení.

Rozhodnout se pro vývoj a používaní nástrojů umělé inteligence pro generování umělé moudrosti vyžaduje kuráž, moudrost, znalost problematiky a víru ve schopnosti lidí ve spolupráci s umělou inteligencí.

Právě uvedené tvrzení neznamená, že se vzdáme regulace vývoje v oblasti AI, tak jak navrhuje Rada EU, která přijala společný postoj – Akt o umělé inteligenci. Jeho cílem je zajistit, aby systémy umělé inteligence, které budou uváděny na trh EU a používány v EU, byly bezpečné a byly v souladu se stávajícími právními předpisy o základních právech a hodnotách EU. Podobné iniciativy existují v USA i jinde. V rámci takových regulací je společný rozvoj inteligentních systémů velkou výzvou, avšak její přínosy budou stát za to. Budou znamenat obrovský, v lidské historii nikdy předtím nevídaný pokrok, srovnatelný s ovládnutím ohně a svým dopadem překonávající průmyslovou revoluci. Moudré systémy umožní lépe a odpovědněji posuzovat vývoj v různých oblastech života lidí, politiky, geopolitiky, dělat lepší rozhodnutí, pomáhat při řešení globálních a jiných praktických problémů a v konečném důsledku žít smysluplnější životy. Stanou se onou zdviží, zmiňovanou v názvu kapitoly, do naší budoucnosti. Znalostní společnost se transformuje na moudrou společnost, societas sapientiae, kterou charakterizuje cílevědomé využívání moudrosti.

Umělá moudrost bude současně představovat společně s přirozenou moudrostí trvalý a smysluplný odkaz naším současníkům i potomkům a bude zvyšovat pravděpodobnost a kvalitu našeho a jejich přežití v proměnlivých budoucích časech a neznámých místech ve Vesmíru.

A jaká je odpověď na Ackoffovu predikci ze závěru 2. sekce ohledně automatů generujících moudrost? Pokud se pod pojmem moudrosti myslí striktně moudrost lidského typu, tak možná má Ackoff pravdu: stroje samotné pravděpodobně nikdy nebudou mít vlastnosti empatie, intuice anebo vědomé zkušenosti, jaké mají lidé. Naše úvahy však naznačují, že umělá moudrost, vzhledem ke své univerzálnosti a šíři problémového prostoru, který má umělá moudrost potenciál pokrýt, bude lidskou moudrost ve většině oblastí předčit. Ale již zmiňovaný pár lidské a umělé moudrosti společně odpovídá naší představě o ideální moudrosti jako prostředku pro formování a naplňování našich ideálů. Taková vize moudrosti posouvá známý Aristotelův výrok „Všichni lidé od přirozenosti touží po vědění“ do ještě vyšší roviny: „Všichni lidé od přirozenosti touží po moudrosti“.

Závěr

Systémy umělé inteligence generující moudrost jsou fundamentálně nové objekty, s jakými se lidstvo doposud nesetkalo. Jejich příchod znamená milník v historii lidstva, protože přináší novou a bezprecedentní formu inteligence, jež bude současně umělá a moudrá a bude komplementární a současně alternativní k naší přirozené inteligenci. Budou daleko lépe rozumět objektivnímu světu prostřednictvím většího množství jejich „smyslů“, než mají lidé, budou se rychleji učit, budou kreativnější. Tyto systémy budou uvažovat a argumentovat podobně jako lidé, avšak vzhledem ke svým zmnoženým kognitivním schopnostem přesahujícím schopnosti lidské se budou opírat o data, informace, znalosti a moudrost, které nebudou nikdy přístupná lidem bez těchto technologií. Doslova se stanou studnicí veškeré moudrosti, kamenem mudrců a svatým grálem lidstva.

Tento splněný sen lidstva však bude mít své stinné stránky.

Pokud se nám nepodaří uspokojivě vyřešit problém souladu systémů generujících moudrost s lidskými hodnotami, bez jejich spolupráce s námi ztratíme své dominantní postavení mezi inteligentními entitami. Budeme konfrontování s Faustovým dilematem – potenciálním kompromisem mezi dobrodiním umělé moudrosti a nebezpečím spojeným s jejím vývojem a používáním. To může znamenat naše existenční ohrožení.

Kterou cestu si zvolíme? Jak se rozhodneme?

A jsme vůbec připraveni se rozhodnout?

Literatura

Ackoff, R.L., From Data to Wisdom - Presidential Address to ISGSR, June 1988, J. Applied Systems Analysis 18 (1989), s. 3-9.

Newen, A., De Bruin, L., Gallagher, S. (eds). The Oxford Handbook of 4E Cognition, Oxford Library of Psychology (2018; online edition, Oxford Academic, 9 Oct. 2018).

Wiedermann, J., van Leeuwen, J., From Knowledge to Wisdom: The Power of Large Language Models in AI. Technical Report UU-PCS-2023-01, červenec 2023.

---

Původně vyšlo v Proč se nebát umělé inteligence. Jota, Praha 2024. Autoři knihy Proč se nebát umělé inteligence? nabízejí střízlivý a odborně podložený pohled na současný stav a perspektivy umělé inteligence (AI). Čtenář se ve srozumitelné podobě dozví, na jakých technologických základech AI stojí, jaká je její historie a jak probíhá zpracování přirozené řeči ve velkých jazykových modelech. Kniha rovněž ukazuje, jak aplikace AI už dnes slouží v průmyslu, zdravotnictví, robotice či v oblasti kybernetické bezpečnosti a jak konkrétně je možné AI využít například ve státní správě či ve službách. Řada příspěvků je věnována filozofickým úvahám o roli a možnostech umělých strojů, etice a právu při jejich využívání.

Report je ke stažení zde.

Lepší andělé: jak nám umělá inteligence může pomoci být morálně lepšími

Tomáš Hříbek